更新时间:2021-10-13 08:52:21

大家好,我是本栏目的编辑郝帅。现在我给大家解释一下上面的问题。尽管有监督的机器学习和深度学习已经取得了成功,但有一个学派认为无监督学习有更大的潜力。监督学习系统的研究受到培训的限制;换句话说,监督学习系统只能学习它训练的任务。相比之下,无监督系统理论上可以实现“人工通用智能”,这意味着它们可以学习人类可以学习的任何任务。然而,这项技术还没有。

如果说监督学习最大的问题是标注训练数据的成本,那么非监督学习(数据不标注)最大的问题就是通常效果不好。然而,无监督学习确实有其用途:有时它可以帮助降低数据集的维度,探索数据的模式和结构,找到相似对象的组,并检测数据中的异常值和其他噪声。

总的来说,作为探索性数据分析的一部分,尝试无监督学习方法来发现模式和聚类、降低数据维度、发现潜在特征和删除异常值是值得的。是需要继续监督学习,还是使用预先训练好的模型进行预测,取决于你的目标和数据。

什么是无监督学习?

想想人类孩子的学习方式。作为家长或老师,你不需要把每一种狗和猫都给孩子看,他们应该教他们认狗认猫。他们可以从一些例子中学习,不需要很多解释,自己总结。哦,他们第一次看到吉娃娃猫的时候可能会误称它为吉娃娃猫,但你可以相对快速地纠正它。

孩子们凭直觉把他们在教室里看到的一些东西分类。无监督学习的一个目标本质上是让计算机发展同样的能力。正如DeepMind的亚历克斯格雷夫斯和凯利克兰西在他们的博客文章“无监督学习:好奇的学生”中所说。

无监督学习就是一个例子,它旨在通过奖励代理(即计算机程序)来创建自主智能,从而在不考虑特定任务的情况下理解他们观察到的数据。换句话说,代理人为了学习而学习。

学习代理的学习潜力远远大于将复杂图片简化为二进制决策的系统(如狗或猫)。发现模式而不是执行预先定义的任务可以产生令人惊讶和有用的结果,正如劳伦斯伯克利实验室的研究人员在数百万份材料科学摘要上运行Word2vec来预测新热电材料的发现所证明的那样。

聚类方法

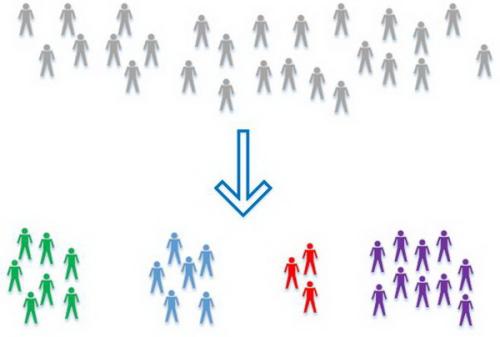

聚类是一个无监督的学习问题,需要模型找到相似的数据点组。目前使用的聚类算法有很多,往往特征略有不同。通常,聚类算法看数据点的特征向量之间的度量或距离函数,然后将那些彼此“接近”的点分组。如果类没有重叠,聚类算法是最有效的。

层次聚类分析(HCA)可以是内聚的(你从一个点开始,从下到上构建一个聚类,从一个聚类开始),也可以是分裂的(你从一个聚类开始,分解它,直到完成一个点)。如果你幸运的话,你可以找到反映有意义分类的聚类过程的中间阶段。

聚类过程通常显示为树形图。HCA算法往往需要大量的计算时间[O(n ^ 3)]和内存[O(n ^ 2)]资源;这些限制了算法对相对较小数据集的适用性。

HCA算法可以使用各种度量和链接标准。欧几里德距离和平方欧几里德距离对于数值数据是常见的。汉明距离和勒温斯坦距离对于非数字数据是常见的。单一环节和完整环节常见;两者都可以简化聚类算法(分别是SLINK和CLINK)。SLINK是少数能够保证找到最优解的聚类算法之一。

k均值聚类

K-means聚类问题试图通过欧氏距离度量将n个观测值分成k个聚类,目的是最小化每个聚类中的方差(平方和)。这是一种矢量量化方法,对特征学习非常有用。

劳埃德算法(带质心更新的迭代聚类)是求解问题最常用的启发式算法,相对有效,但不保证全局收敛性。为了改善这种情况,人们经常使用Forgy或Random Partition方法生成的随机初始聚类的质心多次运行算法。

K-means假设球形聚类是可分的,使得平均值向聚类中心收敛,同时也假设数据点的排序无关。集群的大小应该相似,因此分配到最近的集群中心是正确的分配。

求解K均值聚类的启发式算法通常类似于高斯混合模型的期望最大化算法。

混合模型

混合模型假设观测子群对应于某种概率分布,这种概率分布通常是数值观测的高斯分布或非数值数据的分类分布。每个子组可以有自己的分布参数,如高斯分布的均值和方差。

期望最大化是确定具有给定数量组分的混合物的参数的最流行技术之一。除了EM,混合模型还可以通过马尔可夫链蒙特卡罗、矩匹配、奇异值分解的谱方法和图解法求解。

混合模型的最初应用是通过前额与身体长度的比例来分离两个海岸蟹组。卡尔皮尔逊在1894年用矩匹配法解决了这个问题。

混合模型的一个常见扩展是将定义混合成分识别的潜在变量连接到马尔可夫链,而不是假设它们是具有相同分布的独立随机变量。生成的模型称为隐藏模型。

可夫模型,是最常见的顺序层次模型之一。DBSCAN算法

具有噪声的应用的基于密度的空间聚类(DBSCAN)是一种非参数数据聚类算法,其可以追溯到1996年。它被优化用于可以使用R *树或一些其他几何索引结构加速几何区域查询的数据库。 。

本质上,DBSCAN聚集的核心点在Epsilon的某个距离内具有超过一些最小数量的邻居,丢弃作为Epsilon中没有邻居的异常点,并且在该核心点的Epsilon中添加点到该集群。DBSCAN是最常见的聚类算法之一,可以找到任意形状的聚类。

OPTICS算法

用于识别聚类结构的订购点(OPTICS)是用于在空间数据中查找基于密度的聚类的算法。OPTICS类似于DBSCAN,但处理不同点密度的情况。

DBSCAN和OPTICS中的想法的变化也可用于简单的异常值和噪声检测和去除。

潜变量模型

潜变量模型是将一组可观察变量与一组潜在(隐藏)变量相关联的统计模型。潜变量模型对于揭示复杂和高维数据中的隐藏结构非常有用。

主成分分析

主成分分析(PCA)是一种统计过程,它使用正交变换将可能相关的数值变量的一组观察值转换为称为主成分的线性不相关变量的一组值。Karl Pearson于1901年发明了PCA.PCA可以通过数据协方差(或相关)矩阵的特征值分解或数据矩阵的奇异值分解(SVD)来完成,通常在初始数据的归一化步骤之后。

奇异值分解

奇异值分解(SVD)是实矩阵或复矩阵的分解。这是线性代数中的常用技术,通常使用Householder转换计算。SVD是解决主要组件的一种方法。尽管从头开始编写SVD是完全可能的,但在所有线性代数库中都有很好的实现。

时刻的方法

矩量法使用观测数据样本的时刻(均值,方差,偏度和峰度)来估计总体参数。该方法非常简单,通常可以手工计算,通常可以实现全局收敛。然而,在低统计量的情况下,矩的方法有时可以产生在参数空间之外的估计。矩量法是解决混合模型的简便方法(上图)。

期望最大化算法

期望最大化(EM)算法是一种迭代方法,用于在依赖于未观察到的潜在变量的模型中找到参数的最大似然估计。EM迭代在执行期望步骤(E)和最大化步骤(M)之间交替进行,期望步骤(E)创建用于期望使用参数的当前估计的对数似然的函数,最大化步骤(M)计算使预期对数最大化的参数。在E步骤中发现的可能性。

EM收敛到最大值或鞍点,但不一定达到全局最大值。您可以通过从参数的许多随机初始估计重复EM过程,或通过使用矩的方法来确定初始估计,来增加找到全局最大值的机会。

应用于高斯混合模型(上文)的EM可用于聚类分析。

无监督神经网络

神经网络通常在标记数据上进行训练以进行分类或回归,根据定义,监督机器学习。他们还可以使用各种无监督方案对未标记数据进行培训。

自动编码

自动编码器是在其输入上训练的神经网络。本质上,自动编码器是一个前馈网络,充当编解码器,将其输入从输入层编码到具有较低神经元数的一个或多个隐藏层,然后将编码表示解码为输出层,拓扑结构为输入。

在训练期间,自动编码器使用反向传播来最小化输入和输出之间的差异。自动编码器已被用于降维,特征学习,去噪,异常检测,图像处理和学习生成模型。

深刻的信念网络

深信念网络(DBN)是自动编码器或受限制的玻尔兹曼机器(RBN)的堆栈,可以学习重建其输入。然后这些层充当特征检测器。RBN通常使用对比分歧进行训练。

DBN已被用于生成和识别图像,视频序列和运动捕获数据。

生成性对抗性网络

生成对抗网络(GAN)同时训练两个网络,一个捕获数据分布的生成模型和一个估计样本来自训练数据的概率的判别模型。训练试图最大化发生器欺骗鉴别器的概率。

GAN可用于创建虚构人物的照片并改善天文图像。GAN还被用于升级旧视频游戏中的纹理,以用于高分辨率版本的游戏。在无监督学习之外,GAN已成功应用于游戏的强化学习。

自组织地图

的自组织映射(SOM)限定到一个常规的,通常为二维网格从一组给定的数据项目的有序映射。模型与每个网格节点相关联。数据项将被映射到其模型与数据项最相似的节点,即,在某个度量中与数据项的距离最小。

您需要采取一些预防措施,以确保映射稳定且排序良好。并非所有商业实施都遵循所有预防措施。